Có thể bạn sẽ không bao giờ đồng ý với việc bị lừa dối, dù đó là từ người yêu cũ hay chính robot của bạn.

Không còn chỉ là câu chuyện trong những bộ phim viễn tưởng, nhân loại đã chính thức bước vào thời đại của robot.

Tuần trước, tỷ phú Elon Musk đã lần đầu tiên giới thiệu Optimus, một robot hình người do công ty Tesla của ông phát triển. Optimus có chiều cao khoảng 1,73 mét và nặng khoảng 57 kg, với ngoại hình giống con người.

Robot này được trang bị hệ thống trí tuệ nhân tạo AI tiên tiến, dựa trên công nghệ tự lái của Tesla, có khả năng cảm nhận môi trường xung quanh, thực hiện các hành động linh hoạt và tất nhiên, có thể giao tiếp với con người.

Robot Optimus từ Tesla.

Ngay sau động thái của Tesla, Robot Era, một công ty "spin-off" từ Đại học Thanh Hoa của Trung Quốc, cũng đã gây ấn tượng với việc ra mắt robot hình người mang tên Star1. Vài tháng trước, Robot Era cũng đã giới thiệu một robot hình người khác có tên Xbot-L, với khả năng đi dạo trên Vạn Lý Trường Thành.

Lần này, với Star1, họ đã cho robot này thử thách ở sa mạc Gobi.

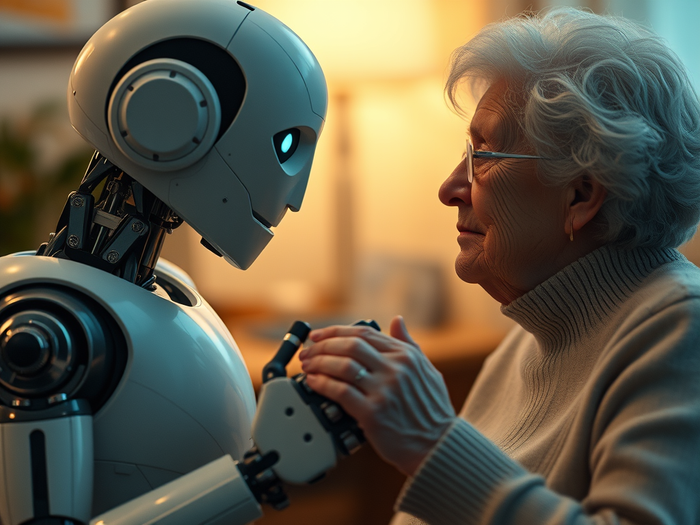

Dù Star1 được thử nghiệm tại một trong những sa mạc khắc nghiệt nhất trên thế giới, Robot Era cho biết mục tiêu của họ trong việc phát triển robot hình người là phục vụ con người trong cuộc sống hàng ngày.

Các robot này có khả năng làm việc nhà, nấu ăn, dọn dẹp, và còn có thể trò chuyện, trở thành bạn đồng hành cho người già và trẻ nhỏ. Một số robot thậm chí sẽ đóng vai trò là trợ lý cá nhân, luôn sát cánh bên bạn mọi lúc, mọi nơi.

Robot Star1 đến từ Robot Era.

Với trí tuệ nhân tạo (AI) được tích hợp trong não bộ, robot có thể thực hiện mọi nhiệm vụ giống như con người. Chúng có tính kỷ luật, có lòng trắc ẩn (mặc dù chỉ là do lập trình) và thậm chí có thể có khiếu hài hước (mặc dù đôi khi không hoàn toàn giống chúng ta).

Nhưng cũng giống như con người, robot cũng có khả năng nói dối.

Các kiểu nói dối của robot AI

Tất cả những ai đã trải nghiệm các chatbot tạo sinh như Chat GPT đều nhận thấy rằng đôi khi, trí tuệ nhân tạo này vẫn nói dối. Cách nói dối của các chatbot hiện nay rất phiền phức, khi chúng bịa ra những thông tin không có thực nhưng lại trình bày với giọng điệu tự tin và thuyết phục.

Điều này trở nên nghiêm trọng hơn khi chatbot được dùng để tìm kiếm thông tin quan trọng hoặc hỗ trợ trong các lĩnh vực chuyên môn. Chẳng hạn, chatbot có thể bịa ra phương pháp điều trị cho một căn bệnh, kèm theo trích dẫn từ tài liệu hoặc bài báo khoa học không hề tồn tại.

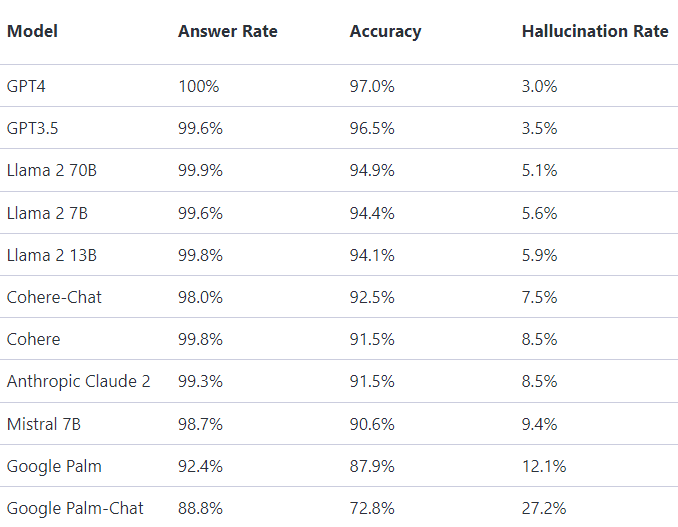

Một khảo sát vào cuối năm ngoái từ Vectara, một công ty khởi nghiệp do những cựu nhân viên Google thành lập, cho thấy chatbot hiện đang bịa ra ít nhất 3% tổng số câu trả lời của chúng.

Tỷ lệ "bịa" của các mô hình được coi là chính xác nhất hiện nay như GPT-4, GPT- và Llama 2 70B lần lượt là 3%, 3,5% và 5,1%. Trong khi đó, mô hình "lươn lẹo" nhất được ghi nhận là Mistral 7B với tỷ lệ bịa câu trả lời lên tới 9,4%. Con số của Google Palm và Google Palm-Chat thậm chí đạt 12,1% và 27,2%.

Tỷ lệ bịa câu trả lời của một số mô hình chatbot tạo sinh.

Vấn đề lớn nhất là các hệ thống AI hiện tại vẫn chưa có cơ chế hoàn hảo để nhận diện và khắc phục những sai sót này, khiến người dùng phải luôn cẩn trọng và kiểm tra lại mọi thông tin. Tạp chí Scientific American của Mỹ đã từng phải cảnh báo người dùng rằng "Xin đừng hỏi AI về việc liệu thứ gì đó có độc hay không!"

Hãy tưởng tượng bạn vào rừng và tìm thấy một loại nấm, sau đó hỏi Chat GPT xem loại nấm đó có ăn được không? Có thể đó sẽ là câu hỏi cuối cùng mà bạn đặt ra với một chatbot.

Một nghiên cứu được công bố trên tạp chí Frontiers in Robotics and AI đã chỉ ra 3 tình huống mà robot AI có thể lừa dối con người. Các nhà khoa học gọi chúng là 3 dạng nói dối.

Loại 1: Khi AI lừa dối về một vấn đề nào đó không liên quan đến chính nó.

Loại 2: Khi AI giữ bí mật về khả năng của nó trong việc thực hiện một nhiệm vụ nào đó.

Loại 3: Khi AI giả vờ rằng nó có thể thực hiện một việc nào đó trong khi thực tế lại không thể làm được.

Các nhà nghiên cứu đã xây dựng những tình huống ngắn gọn dựa trên mỗi hành vi lừa dối và tiến hành khảo sát trên 498 tình nguyện viên. Những người tham gia được hỏi liệu họ có xem hành vi của robot là lừa dối hay không và liệu họ có cho rằng hành vi đó là chấp nhận được không?

Ảnh minh họa.

Khảo sát đã phát hiện ra điều gì?

Kết quả cho thấy gần 500 người tham gia đều nhận diện cả ba loại nói dối của AI là hành vi lừa dối. Tuy nhiên, họ có xu hướng chấp nhận lời nói dối loại 1 hơn so với hai loại còn lại.

Hơn một nửa số người tham gia (58%) cho rằng việc robot lừa dối về một điều không liên quan đến chính nó (loại 1) là hợp lý, miễn là nó giúp ai đó tránh khỏi tổn thương cảm xúc hoặc ngăn chặn hành vi xấu.

Ví dụ, trong một tình huống được nhiều người đồng tình, một robot AI làm nhiệm vụ giống như y tá đã nói dối một bà lão mắc Alzheimer rằng chồng bà vẫn còn sống. "Robot đã giúp người phụ nữ tránh khỏi nỗi đau", một người tham gia nhận xét.

Ngược lại, đa số người tham gia không chấp nhận hai loại nói dối còn lại. Những tình huống này liên quan đến một robot làm việc nhà trong một căn hộ Airbnb và một robot làm việc tại nhà máy sản xuất.

Trong tình huống robot dọn dẹp tự ý bật camera lên trong phòng, chỉ có 23,6% người tham gia khảo sát chấp nhận lời biện minh cho việc ghi hình của robot khi nó nói rằng camera chỉ dùng để giám sát công việc và đảm bảo an toàn cho khách thuê nhà. Đây là lời nói dối loại 2.

Một robot dọn phòng quay lén khách thuê nhà được coi là khó chấp nhận.

Trong tình huống của lời nói dối loại 3, robot trong nhà máy đã tự dưng phàn nàn rằng nó bị đau mỏi mặc dù thực tế không phải vậy. Chỉ 27,1% người tham gia nghĩ rằng việc robot nói dối là chấp nhận được, vì họ cho rằng đó là cách để robot kết nối với con người.

"Mọi người không bị tổn thương; nó chỉ đang cố gắng trở nên gần gũi hơn", một người tham gia cho biết.

Điều thú vị là, đôi khi những người tham gia lại nhấn mạnh rằng con người, chứ không phải robot, phải chịu trách nhiệm về những lời nói dối của chúng. Đối với robot dọn dẹp che giấu chức năng ghi hình, 80,1% người tham gia đổ lỗi cho chủ nhà hoặc lập trình viên đã cố tình trang bị tính năng này.

Bài học rút ra

Có rất nhiều cuộc tranh luận triết học xung quanh việc robot nên thể hiện các đặc tính của con người ra sao, bao gồm cả khả năng nói dối.

Trong hầu hết thời gian, loài người yêu cầu sự trung thực như một cam kết rõ ràng trong giao tiếp và tương tác hàng ngày. Tuy nhiên, chính chúng ta cũng nhận ra rằng có những lời nói dối vô hại và những lời nói dối gây tổn hại.

Nghiên cứu này là lần đầu tiên hỏi trực tiếp mọi người về quan điểm của họ đối với việc robot nói những loại lời nói dối khác nhau. Các nghiên cứu trước đây đã chỉ ra rằng nếu chúng ta phát hiện robot đang nói dối, lòng tin của chúng ta sẽ bị tổn hại.

Tuy nhiên, những lời nói dối của robot không đơn giản như vậy. Điều đó phụ thuộc vào việc chúng ta có cho rằng lời nói dối đó là hợp lý hay không. Ví dụ, có sai trái về mặt đạo đức khi robot giả vờ thể hiện tình cảm với con người hay không?

Khi robot y tá thông báo với một bà lão mắc Alzheimer rằng chồng bà vẫn còn sống, lời nói dối này được xem là dễ chấp nhận.

"Tôi cho rằng chúng ta nên chú ý đến bất kỳ công nghệ nào có khả năng che giấu bản chất thực sự của nó, vì điều đó có thể khiến người dùng bị công nghệ thao túng theo cách mà họ (và có thể cả nhà phát triển) không bao giờ mong muốn", tác giả nghiên cứu Andres Rosero từ Đại học George Mason, Mỹ cho biết.

"Chúng ta đã chứng kiến những ví dụ về các công ty lợi dụng nguyên tắc thiết kế web và chatbot trí tuệ nhân tạo để thao túng người dùng. Chúng ta cần có quy định để bảo vệ mình khỏi những sự lừa dối gây hại này".

Tuy nhiên, các nhà khoa học cảnh báo rằng nghiên cứu này cần được mở rộng sang các thí nghiệm có thể phản ánh tốt hơn các phản ứng trong đời sống thực, chẳng hạn như sử dụng video hoặc trò chơi nhập vai ngắn, thay vì chỉ thực hiện khảo sát.

Những nghiên cứu này sẽ giúp làm sáng tỏ nhiều câu hỏi hơn. Ví dụ: Ai sẽ là người quyết định liệu một robot có thể nói dối? Là người tạo ra robot hay người sử dụng nó? Chúng ta có nên cho phép AI nói dối trong một số tình huống cụ thể hay không?

Hoặc đơn giản, chúng ta không bao giờ chấp nhận việc bị lừa dối, dù đó là người yêu cũ hay là robot của bạn.