Với việc đầu tư hàng tỷ USD vào việc phát triển kiến trúc GPU mới, có khả năng cao Nvidia sẽ thu hồi lại số vốn khổng lồ này bằng cách bán những GPU B200 mới ra mắt với mức giá cực kỳ cao, gấp nhiều lần chi phí gia công tại TSMC, tương tự như hai thế hệ chip H100 và H200 trước đó. Thông tin không chính thức cho biết, chi phí gia công của Nvidia H200, kiến trúc Hopper chỉ khoảng 4500 USD, nhưng mức giá bán ra thị trường dao động từ 25 đến 40 nghìn USD mỗi chip.

Một nguồn tin tiết lộ rằng, để phát triển chip Blackwell này, Nvidia đã bỏ ra 10 tỷ USD, vì vậy, kiến trúc GPGPU mới này phải có hiệu suất xử lý AI quy mô lớn đáng kể, ít nhất là gấp đôi so với H200.

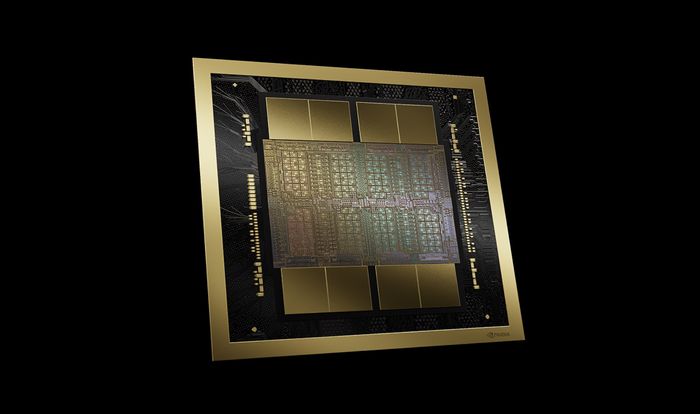

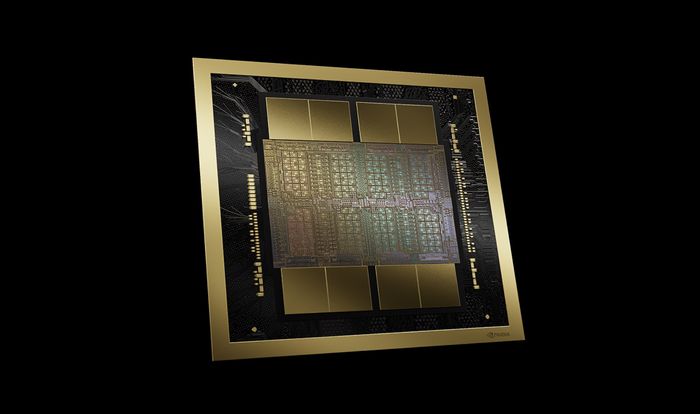

Với số tiền đầu tư này, Nvidia kỳ vọng tỷ suất hoàn vốn (ROI) sẽ rất cao. Theo kênh CNBC, CEO Jensen Huang của hãng đã tuyên bố rằng mỗi GPU Blackwell B200 sẽ được bán ra thị trường với mức giá từ 30 đến 40 nghìn USD.Một nguồn tin khác cho biết rằng, mỗi chip B200 với 2 die GPU thiết kế MCM có chi phí gia công hơn 6 nghìn USD, cao hơn cả chi phí gia công chip Hopper H200. Lựa chọn thiết kế chiplet là vì mỗi die trên chip B200 có kích thước tối đa mà công nghệ hiện tại có thể gia công, trên tiến trình 4NP của TSMC. Để đạt được hiệu suất xử lý AI gấp từ 2 đến 5 lần so với Hopper, Nvidia phải ghép 2 die GPU lại để tạo ra 1 con chip hoàn chỉnh.GPU B200 có 104 tỷ transistor trên mỗi die GPU, tổng cộng 2 die MCM là 208 tỷ transistor, chia thành 160 Stream Microprocessor, tương đương với 20480 nhân CUDA. Chip này được hợp tác sản xuất bởi Synopsys và TSMC, áp dụng công nghệ và thư viện phần mềm CuLitho của Nvidia, sử dụng sức mạnh của máy tính để tăng tốc quá trình nghiên cứu và phát triển chip. So với Hopper, B200 có thêm 128 tỷ transistor. Hiệu suất xử lý số thực dấu phẩy động FP8 và FP6 của B200 nhanh gấp 2.5 lần, xử lý FP4 nhanh gấp 5 lần so với H200.Trên bề mặt của con chip này là 8 stack chip nhớ HBM3e, có dung lượng tối đa là 192GB, tốc độ 8TB/s, hoạt động trên giao diện bus 8192-bit. Công suất tiêu thụ điện tối đa của con chip này là 700W, con số này tương tự như các con chip H100 và H200 hiện đang có trên thị trường, được sử dụng trong các hệ thống trung tâm dữ liệu để vận hành mô hình AI của các tập đoàn lớn.Theo WCCFTech