(Quốc Gia) - MI300X là bộ xử lý dành cho trung tâm dữ liệu của AMD, được thiết kế để đào tạo trí tuệ nhân tạo, hứa hẹn sẽ cạnh tranh với các sản phẩm mới nhất từ Nvidia.

AMD sẽ chính thức ra mắt MI300X - loại GPU dành cho các nhiệm vụ trí tuệ nhân tạo của họ vào cuối năm nay, theo thông báo được công bố hôm nay. Điều này được xem là bước tiến lớn của Đội Đỏ (biệt danh của AMD) để đối phó với đối thủ trong lĩnh vực GPU là Nvidia, đang chiếm 80% thị phần chip trí tuệ nhân tạo theo các chuyên gia phân tích.

Kể từ khi trí tuệ nhân tạo bùng nổ, GPU chuyên dụng đã trở thành thiết bị không thể thiếu cho các công ty công nghệ như OpenAI để phát triển các chương trình trí tuệ nhân tạo tiên tiến như ChatGPT.

Theo các chuyên gia phân tích, nếu chip do AMD sản xuất (được gọi là bộ gia tốc trí tuệ nhân tạo) được các nhà phát triển trí tuệ nhân tạo và nhà sản xuất máy chủ chấp nhận để thay thế cho sản phẩm của Nvidia, nó có thể mở ra một thị trường tiềm năng lớn cho Đội Đỏ, nổi tiếng với các loại chip cho máy tính truyền thống.

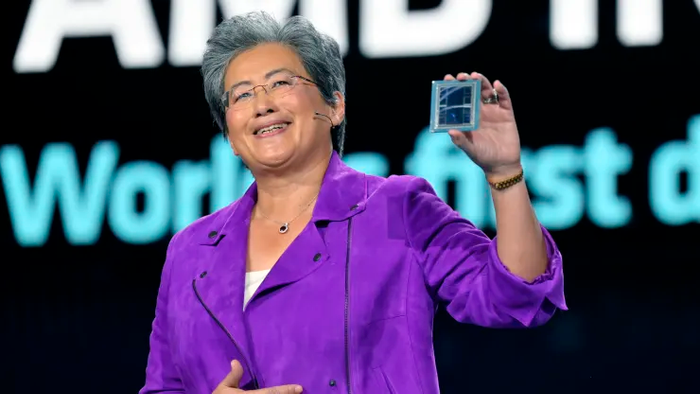

CEO Lisa Su của AMD trưng bày một con chip AMD Instinct MI300X khi đang phát biểu tại CES 2023. Bà nhấn mạnh, trí tuệ nhân tạo là 'cơ hội tăng trưởng lớn và chiến lược nhất' của công ty này.

'Chúng tôi tin rằng [thị trường] các thiết bị gia tốc trí tuệ nhân tạo cho các trung tâm dữ liệu sẽ tăng từ khoảng 30 tỷ USD trong năm nay, với tốc độ tăng trưởng hàng năm trên 50%, lên hơn 150 tỷ USD vào năm 2027,' CEO AMD Lisa Su tuyên bố.

Mặc dù AMD không công bố giá bán của các chip trí tuệ nhân tạo của mình, nhưng hành động này có thể tạo áp lực về giá cho GPU của Nvidia, như dòng H100, được cho là có giá từ 30.000 USD trở lên. Tất nhiên, việc giảm giá GPU trí tuệ nhân tạo có thể giúp giảm chi phí cho việc triển khai các ứng dụng trí tuệ nhân tạo tổng quát, mà hiện đang tốn kém.

AMD thông báo rằng chip MI300X mới và kiến trúc CDNA của nó được thiết kế cho các mô hình ngôn ngữ lớn và các mô hình trí tuệ nhân tạo tiên tiến khác. MI300X có thể hỗ trợ dung lượng bộ nhớ lên đến 192GB, điều này có nghĩa là nó có thể phù hợp với các mô hình trí tuệ nhân tạo lớn hơn so với các chip trên thị trường.

Ví dụ, GPU H100 của Nvidia chỉ hỗ trợ dung lượng bộ nhớ lên đến 120GB. Các mô hình ngôn ngữ lớn cho các ứng dụng trí tuệ nhân tạo tổng quát đòi hỏi nhiều bộ nhớ, bởi vì các mô hình này đang tiến hành tính toán ngày càng nhiều.

Được biết, AMD đã chạy thử chip MI300X trên một mô hình có 40 tỷ tham số được gọi là Falcon. So sánh, mô hình GPT-3 của OpenAI có 175 tỷ tham số.

'Kích thước của các mô hình ngôn ngữ ngày càng lớn và thật sự bạn cần nhiều GPU để chạy các mô hình mới nhất,' CEO Lisa Su nói.

Tuy nhiên, CEO AMD khẳng định, với dung lượng bộ nhớ mở rộng của MI300X, các nhà phát triển trí tuệ nhân tạo sẽ không cần phải trang bị thêm nhiều GPU.

Một tập hợp thiết bị chứa 8 chip xử lý trí tuệ nhân tạo MI300X của AMD. Ảnh: Servethehome

AMD cũng thông báo họ sẽ cung cấp công nghệ Kiến trúc Vô cực, kết hợp sức mạnh của tám bộ gia tốc M1300X trong một hệ thống duy nhất. Trước đó, Nvidia và Google cũng đã phát triển các hệ thống tương tự, kết hợp tám GPU trở lên trong một thiết bị đơn cho các ứng dụng trí tuệ nhân tạo.

Một trong những lý do khiến các nhà phát triển trí tuệ nhân tạo ưa chuộng chip Nvidia trước đây là vì hãng này sở hữu gói công cụ CUDA phát triển rất mạnh mẽ, cho phép truy cập vào các tính năng phần cứng cốt lõi của chip. Để cạnh tranh với CUDA, AMD cũng đã phát triển một bộ công cụ riêng cho trí tuệ nhân tạo có tên là ROCm.

'Mặc dù vẫn là một hành trình mới của AMD trên thị trường trí tuệ nhân tạo, nhưng chúng tôi đã đạt được tiến bộ đáng kể trong việc xây dựng một hệ sinh thái phần mềm mạnh mẽ hoạt động với các mô hình, thư viện, khung và công cụ,' Chủ tịch AMD Victor Peng nói.

Đối với Nvidia, với sự bùng nổ của trí tuệ nhân tạo, nhu cầu mua các thiết bị để nghiên cứu đã tăng mạnh, dẫn đến tăng trưởng doanh thu đáng kể. Theo CNBC, Nvidia đã trở thành hãng sản xuất chip đầu tiên đạt mốc giá trị vốn hóa 1.000 tỷ USD, gia nhập CLB vốn hóa nghìn tỷ USD cùng với Apple, Microsoft, Alphabet và Amazon.

Các chip H100 của Nvidia được các công ty Big Tech như Microsoft và Amazon cũng như các startup AI như OpenAI, Anthropic, Stability Ai và Infection AI ưa chuộng. Lý do là vì hiệu suất cao của chúng, giúp giảm chi phí đào tạo AI hoặc tăng tốc độ phát triển và ra mắt sản phẩm.

Gần đây, Nvidia đã giới thiệu DGX GH200 - mẫu GPU xử lý trí tuệ nhân tạo mới nhất. Nền tảng siêu máy tính AI này được tạo ra từ việc kết hợp 256 siêu chip Grace Hopper Superchips trên bộ nhớ chia sẻ 144TB, cho phép xử lý các tác vụ huấn luyện AI với hiệu suất tốt nhất hiện nay.

Tham khảo CNBC/Bloomberg