Trong năm 2024, việc áp dụng nhiều ứng dụng AI cho người tiêu dùng không còn là điều xa lạ, như ChatGPT của OpenAI hoặc AI Pin của Humane. Tuy nhiên, những ứng dụng này chỉ là một phần nhỏ của hành trình phát triển AI.

Trong năm 2024, việc áp dụng nhiều ứng dụng AI cho người tiêu dùng không còn là điều xa lạ, như ChatGPT của OpenAI hoặc AI Pin của Humane. Tuy nhiên, những ứng dụng này chỉ là một phần nhỏ của hành trình phát triển AI.Đằng sau hậu trường, cuộc đua AI đang diễn ra gay gắt: bất kể là phần mềm hay phần cứng dựa trên AI, thành công của chúng đều phụ thuộc vào việc sản xuất chip. Một số sản phẩm hoặc dịch vụ AI tận dụng khả năng xử lý AI trên thiết bị (on-device AI), trong khi các sản phẩm khác chuyển yêu cầu sang máy chủ đám mây (Cloud AI). Dù cách tiếp cận nào, bộ xử lý AI vẫn là trụ cột của AI, và đó chính là lý do các công ty công nghệ lớn đang dốc sức tham gia vào cuộc đua để tạo ra bộ xử lý AI tốt nhất cho AI PC và máy chủ đám mây.

Tại sao chip lại quan trọng đối với hiệu suất của AI?

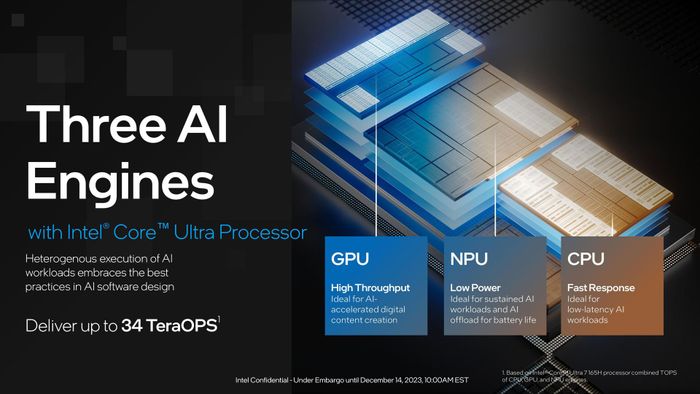

Smartphone đã sử dụng từ lâu và laptop cũng bắt đầu tích hợp các bộ xử lý trí tuệ nhân tạo (NPU), được thiết kế để xử lý các tác vụ liên quan đến AI. NPU có khả năng xử lý và phân tích thông tin đồng thời tốt hơn nhiều so với CPU hoặc GPU truyền thống. Vì vậy, việc sử dụng NPU không chỉ giúp tính toán AI nhanh hơn, mà còn hỗ trợ các quy trình làm việc đòi hỏi cao hơn. Đây là lý do tại sao Apple đã tích hợp SoC với NPU vào cả iPhone và các thiết bị di động của họ trong nhiều năm qua. NPU cũng đã trở thành một phần quan trọng của phần cứng PC khi cả Intel và AMD đều tích hợp NPU vào chip của họ. CPU Intel Core Ultra tích hợp NPU

CPU Intel Core Ultra tích hợp NPU GPU Nvidia H100

GPU Nvidia H100

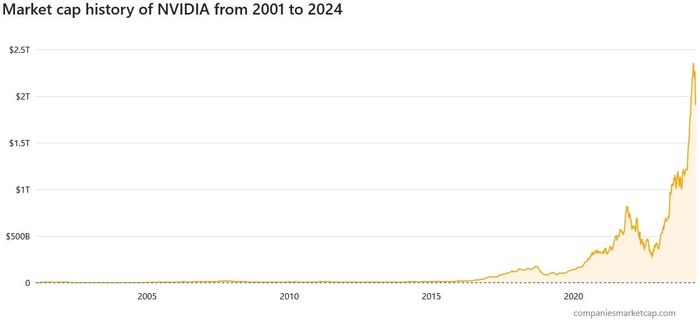

Tất cả các công ty trong ngành đều quan tâm đến các sản phẩm GPU tiên tiến của Nvidia, bao gồm cả H100 và H200 mới được công bố. Những con chip này rất quan trọng để chạy các mô hình ngôn ngữ lớn LLM và hỗ trợ nhiều tính năng AI, từ chatbot đến các ứng dụng tạo ảnh và tạo video. Các công ty như Google, Microsoft và OpenAI đều cần chip AI tiên tiến để cung cấp sức mạnh cho dịch vụ của họ. Thay vì chỉ tập trung vào việc phát triển các công cụ phần mềm AI, họ cũng đang thi đua để thiết kế và mua các chip để đưa các ứng dụng AI của họ vào cuộc sống.

Mọi công ty đều muốn tham gia vào việc phát triển chip AI

Đó là lý do khi nhắc đến bất kỳ công ty công nghệ lớn nào, chúng ta đều nghe đến việc họ sản xuất, thiết kế hoặc chế tạo chip AI dưới nhiều hình thức khác nhau:

- Trong tuần vừa qua, Google đã công bố một loại chip mới có tên là Google Axion. Đây là một loại chip Arm tuỳ chỉnh được thiết kế cho các trung tâm dữ liệu hỗ trợ Google Cloud

- Microsoft đang phát triển Azure Maia và Azure Cobalt, 2 loại chip AI sắp ra mắt trong năm nay để giảm sự phụ thuộc vào các sản phẩm của Nvidia

- Meta đã bước vào lĩnh vực sản xuất chip với con chip MTIA (Meta Training and Inference Accelerator) vào năm ngoái và đang xem xét thế hệ tiếp theo

- Amazon Web Services đã giới thiệu bộ xử lý Trainium2 tuỳ chỉnh mới cho các tác vụ AI, đồng thời sử dụng chip Nvidia cho các trung tâm dữ liệu của mình

- CEO của OpenAI, Sam Altman, cũng được cho là đang xem xét việc sử dụng các bộ xử lý AI tuỳ chỉnh

Amazon giới thiệu chip Trainium2

Amazon giới thiệu chip Trainium2Các công ty đã đề cập đều dựa vào Nvidia và đã tập trung nhiều vào mối quan hệ dài hạn với hãng chip này. Nhưng điều này sẽ không kéo dài mãi mãi: Amazon, Microsoft, Google và Meta đều đang phát triển các giải pháp chip thay thế riêng của họ. Công ty nào có thể cạnh tranh được với Nvidia có thể sẽ giành chiến thắng cuối cùng trong cuộc đua AI.

Sản xuất chip AI cũng mang lại lợi nhuận lớn

Vì vậy, không khó để nhận thấy các công ty đang cạnh tranh nhau để phát triển các tính năng phần mềm và mô hình ngôn ngữ lớn hơn. Tuy nhiên, Microsoft, Google, Amazon và Meta cũng cần phải cạnh tranh về phần cứng để giành chiến thắng trong lĩnh vực phần mềm. Hai khía cạnh này của AI liên kết chặt chẽ với nhau, ít nhất là trong ngữ cảnh thị trường hiện tại.

Nvidia hiện đang là ông vua của lĩnh vực AI và thành công của các công ty khác phụ thuộc vào việc sử dụng GPU của Nvidia. Thành công của Nvidia cũng thể hiện rõ sự động viên từ khía cạnh tài chính: tại thời điểm này, giá cổ phiếu của Nvidia đã tăng 218,5% trong năm qua và họ đã trở thành một trong những công ty tỷ đô nhờ sự thống trị trong lĩnh vực sản xuất chip AI.

Và nếu có một bài học có thể rút ra từ sự bùng nổ của AI hiện nay, đó có lẽ là các công ty công nghệ sẽ tồn tại lâu dài hơn nếu họ có thể tự chế tạo thành công phần cứng AI của riêng mình.