Cuộc đua về hiệu suất chip xử lý dành cho dịch vụ trí tuệ nhân tạo tích hợp trong máy chủ đám mây đang khiến các đơn vị vận hành máy chủ này phải tính toán lại chi phí để mua hàng nghìn, thậm chí hàng chục nghìn chip GPGPU dành riêng cho việc xử lý mô hình AI.

TensorWave, một công ty khởi nghiệp, đã chọn sử dụng chip MI300X của AMD thay vì H100 của Nvidia để trang bị cho data center của họ. Theo TensorWave, chi phí thuê máy chủ vận hành dịch vụ AI với chip MI300X sẽ chỉ bằng một phần so với chi phí của máy chủ trang bị chip H100.

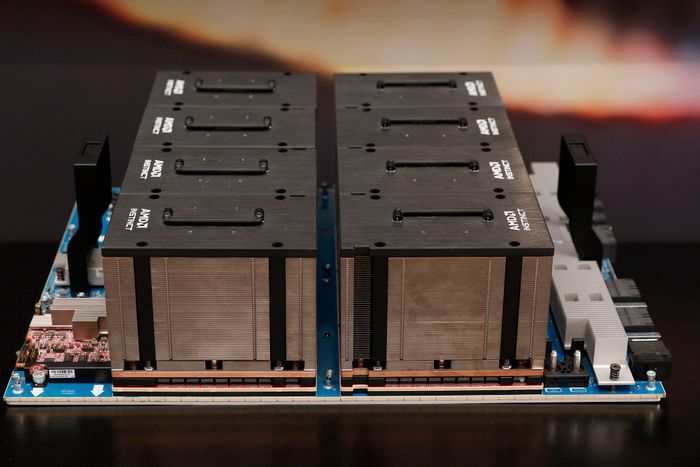

TensorWave, một công ty khởi nghiệp, đã chọn sử dụng chip MI300X của AMD thay vì H100 của Nvidia để trang bị cho data center của họ. Theo TensorWave, chi phí thuê máy chủ vận hành dịch vụ AI với chip MI300X sẽ chỉ bằng một phần so với chi phí của máy chủ trang bị chip H100.Trong tương lai gần, TensorWave định kết nối toàn bộ máy chủ với nhau thông qua công nghệ FabreX sử dụng giao thức PCIe 5.0 của GigaIO. Họ muốn tổng hợp 5750 GPU thành một hệ thống để quản lý và phân chia công việc dễ dàng hơn, với tổng cộng hơn 1 petabyte bộ nhớ HBM3 tốc độ cao.