Apple chia sẻ rằng Mô hình Nền tảng Apple (AFM) dựa trên cụm đám mây vi xử lý tensor (TPU) v4 và v5p từ Google

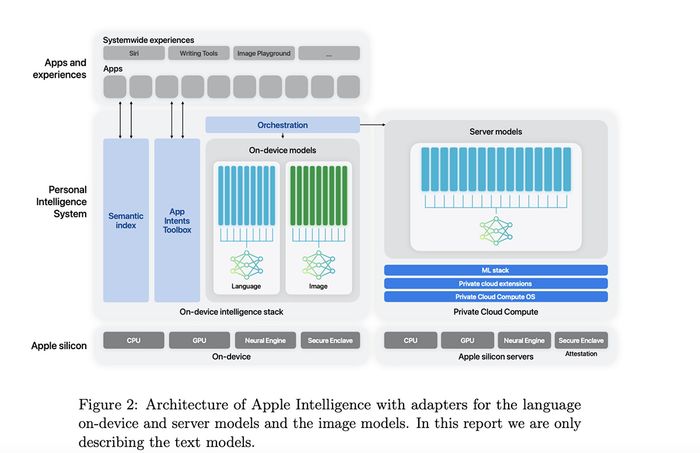

Báo cáo nghiên cứu mới của Apple được công bố sáng nay tập trung vào hạ tầng đào tạo và các chi tiết khác của các mô hình AI được giới thiệu tại WWDC vào tháng 6. Apple đã giới thiệu nhiều tính năng AI khác nhau bao gồm cả tính năng xử lý đám mây và trực tiếp trên thiết bị. Tất cả những tính năng này được gọi là Mô hình Nền tảng Apple hay AFM.

Đối với AFM trên máy chủ, Apple cho biết họ đã huấn luyện một mô hình AI với 6.3 nghìn tỷ token từ đầu trên 8,192 chip TPUv4. Chip TPUv4 của Google được sử dụng trong các container với mỗi container chứa 4,096 chip.

Apple cũng cho biết rằng các mô hình AFM (trên cả thiết bị và đám mây) đều được huấn luyện trên chip TPUv4 và cụm TPU đám mây v5p. v5p là một phần của 'Siêu máy tính' AI đám mây của Google và đã được công bố vào tháng 12 năm ngoái.

Mỗi pod v5p được tạo thành từ 8,960 chip và theo Google, nó cung cấp gấp đôi số phép toán dấu phẩy động mỗi giây (FLOPS) và gấp ba lần bộ nhớ so với TPU v4 để huấn luyện mô hình nhanh hơn gần ba lần.

Đối với mô hình AI trên thiết bị để các tính năng như viết và chọn hình ảnh, Apple sử dụng mô hình với 6.4 tỷ tham số được huấn luyện từ đầu bằng cùng công thức như máy chủ AFM. Theo Apple, mô hình này đã được huấn luyện trên 2048 chip TPU v5p.

Các chi tiết khác được chia sẻ trong bài báo bao gồm đánh giá mô hình cho các phản hồi có hại, các chủ đề nhạy cảm, độ chính xác của sự kiện, hiệu suất toán học và sự hài lòng của con người với đầu ra của mô hình. Theo Apple, máy chủ AFM và các mô hình trên thiết bị dẫn đầu trong ngành về việc ngăn chặn các đầu ra có hại.

Ví dụ, máy chủ AFM so với GPT-4 của OpenAI có tỷ lệ vi phạm đầu ra có hại là 6.3%, thấp hơn nhiều so với 28.8% của GPT-4 theo dữ liệu của Apple. Tương tự, trên thiết bị, tỷ lệ vi phạm 7.5% của AFM thấp hơn 21.8% của Llama-3-8B (do Meta, công ty mẹ của Facebook đào tạo).

Đối với việc tóm tắt email, tin nhắn và thông báo, AFM trên thiết bị có tỷ lệ hài lòng lần lượt là 71.3%, 63% và 74.9%. Bài nghiên cứu cho biết những con số này vượt trội so với Llama, Gemma và Phi-3.

Vấn đề tại sao Apple lại chọn chip Google để huấn luyện mô hình AI thay vì sử dụng GPU của NVIDIA - một giải pháp được cho là hiệu quả nhất và tốc độ đào tạo AI nhanh nhất hiện nay - vẫn còn mơ hồ. Có lẽ chi phí và mối quan hệ tốt giữa Apple và Google là những yếu tố quan trọng đã ảnh hưởng đến quyết định này.

- Cuộc chia ly giữa NVIDIA và Apple: AMD có phải là người thứ ba?

- Trí tuệ Apple vs Copilot+ PC: AI nào tốt hơn cho máy tính?

Nếu bạn muốn trải nghiệm sớm các tính năng AI của Apple, hãy tham khảo ngay các dòng MacBook hiện có tại Mytour: