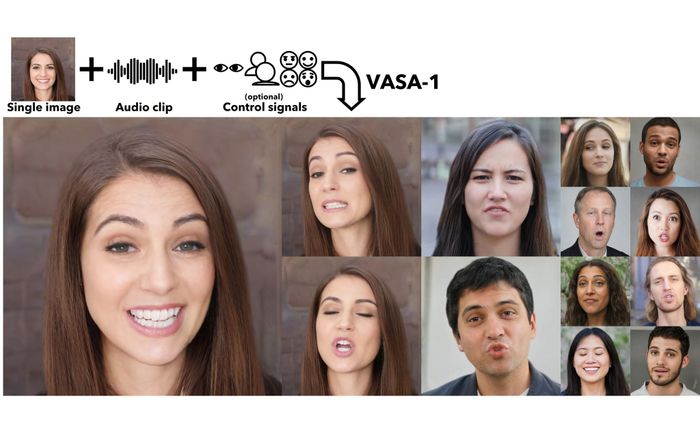

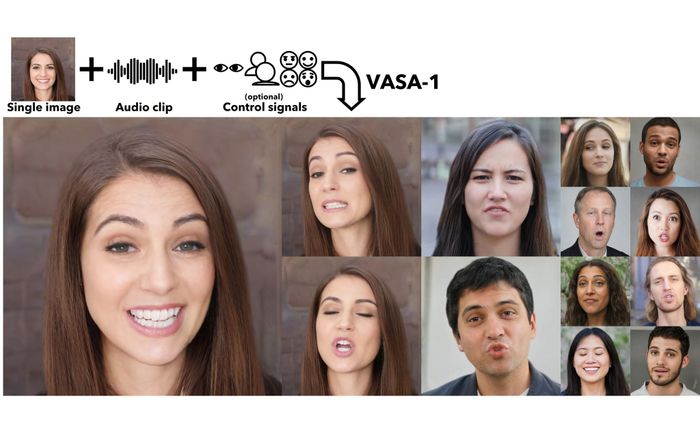

VASA-1, một dự án nghiên cứu của Microsoft châu Á, có khả năng tạo ra video lip sync từ một bức ảnh và một đoạn ghi âm, hiển thị đầy đủ biểu cảm khuôn mặt, góc nhìn, chuyển động đầu, mắt, miệng và các cơ liên quan. Tất cả được tạo ra bởi trí tuệ nhân tạo ngay lập tức.

Theo nhóm nghiên cứu, VASA không chỉ đồng bộ chuyển động miệng với âm thanh mà còn tạo ra nhiều biến thể khác trên khuôn mặt để đảm bảo tính thực tế. Họ nói rằng mô hình đã xử lý tất cả các biến thể trên khuôn mặt và góc nhìn trong không gian latent để tạo ra video cuối cùng với độ phân giải 512 x 512, tốc độ khung hình 40 fps và không có độ trễ đáng kể giữa âm thanh và hình ảnh.

VASA có thể hoạt động trên một desktop với GPU 4090, độ trễ khi phát video trực tiếp chỉ là 170ms.Hiện tại, nhóm nghiên cứu chưa có kế hoạch công bố API hoặc sản phẩm cụ thể liên quan đến VASA. Dưới đây là một số ví dụ về chân dung được tạo ra bằng StyleGAN2 hoặc DALL.E-3. Mời mọi người tham khảo.

Trước hết là một số video có độ dài khoảng 1 phút được tạo ra từ hình ảnh tĩnh và giọng nói.Thêm nhiều lựa chọn giọng nóiDù cùng một người nhưng có nhiều góc mặt khác nhau, bạn có thể nhận thấy sự thay đổi trong cử chỉ như nhìn, hít thở,...

Đa dạng về khoảng cáchSự đa dạng của biểu cảm khi nói của một ngườiDưới đây là một video thể hiện khả năng tạo ra video trong không gian ba chiềuNội dung được phát triển bởi đội ngũ Mytour với mục đích chăm sóc khách hàng và chỉ dành cho khích lệ tinh thần trải nghiệm du lịch, chúng tôi không chịu trách nhiệm và không đưa ra lời khuyên cho mục đích khác.

Nếu bạn thấy bài viết này không phù hợp hoặc sai sót xin vui lòng liên hệ với chúng tôi qua email [email protected]