Từ hôm nay, người dùng có thể trải nghiệm GPT- mini.

OpenAI vừa công bố GPT- mini, một mô hình trí tuệ nhân tạo nhỏ gọn mới nhất. GPT- mini được cho là có chi phí thấp hơn và hiệu suất nhanh hơn các mô hình AI hiện tại, đang được cung cấp cho các nhà phát triển và người dùng thông qua ứng dụng web và di động , và dự kiến sẽ có mặt cho người dùng doanh nghiệp vào tuần tới.

Theo OpenAI, GPT- mini vượt trội so với các mô hình AI nhỏ hàng đầu hiện tại trong các nhiệm vụ liên quan đến văn bản và hình ảnh. Khi các mô hình AI nhỏ ngày càng được cải thiện, chúng trở nên phổ biến hơn với các nhà phát triển nhờ tốc độ và hiệu quả chi phí so với các mô hình lớn như GPT-4 Omni hoặc Claude Sonnet. Chúng là lựa chọn lý tưởng cho các nhiệm vụ đơn giản và khối lượng lớn mà nhà phát triển cần mô hình AI thực hiện nhiều lần.

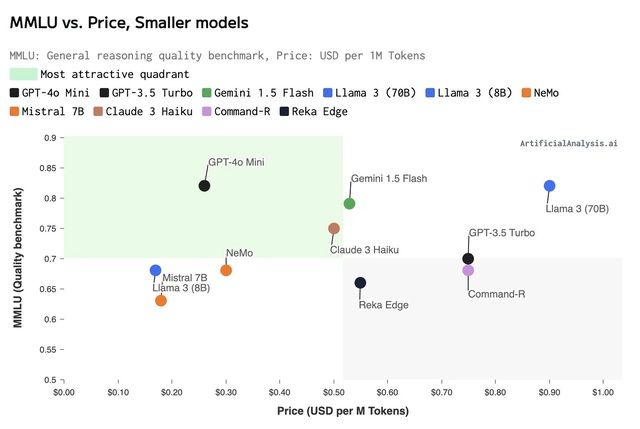

GPT- mini sẽ thay thế GPT- Turbo trở thành mô hình nhỏ nhất mà OpenAI cung cấp. Theo OpenAI, GPT- mini đạt 82% điểm trên MMLU, một tiêu chuẩn đo lường khả năng lý luận, so với 79% của Gemini 1.5 Flash và 75% của Claude 3 Haiku (dữ liệu từ Artificial Analysis). Trong công cụ đo lường khả năng toán học MGSM, GPT- mini đạt 87%, so với 78% của Flash và 72% của Haiku.

OpenAI cũng cho biết chi phí vận hành GPT- mini tiết kiệm hơn đáng kể so với các mô hình trước đó, giảm đến 60% so với GPT- Turbo. Hiện tại, GPT- mini hỗ trợ xử lý văn bản và hình ảnh qua API, và trong tương lai, OpenAI dự định sẽ mở rộng khả năng xử lý video và âm thanh cho mô hình này.

Olivier Godement, Giám đốc API Sản phẩm của OpenAI, phát biểu trong cuộc phỏng vấn với TechCrunch rằng: 'Để AI có thể hỗ trợ mọi ngóc ngách trên thế giới, chúng ta cần làm cho các mô hình trở nên dễ tiếp cận hơn nhiều.' Ông cho rằng GPT- mini là một bước tiến lớn theo hướng đó.

Đối với các nhà phát triển sử dụng API của OpenAI, chi phí sử dụng GPT- mini là 15 cent cho mỗi triệu token đầu vào và 60 cent cho mỗi triệu token đầu ra. Mô hình có cửa sổ ngữ cảnh lên đến 128.000 token, tương đương với độ dài của một cuốn sách, và dữ liệu được cập nhật đến tháng 10/2023.

OpenAI không công bố kích thước chính xác của GPT- mini, nhưng cho biết nó tương đương với các mô hình AI nhỏ như Llama 3 8b, Claude Haiku và Gemini 1.5 Flash. Theo các bài kiểm tra trước khi ra mắt trên LMSYS.org, OpenAI khẳng định GPT- mini nhanh hơn, tiết kiệm chi phí hơn và thông minh hơn các mô hình nhỏ hàng đầu hiện tại. Các bài kiểm tra độc lập cũng dường như xác nhận điều này.

'GPT- mini cho tốc độ hoạt động rất nhanh, với trung bình 202 token mỗi giây', George Cameron, Đồng sáng lập tại Artificial Analysis, chia sẻ qua email gửi TechCrunch. 'Điều này nhanh gấp đôi so với GPT- và GPT- Turbo, làm cho nó trở thành sự lựa chọn hấp dẫn cho các trường hợp sử dụng yêu cầu tốc độ cao, bao gồm nhiều ứng dụng người tiêu dùng và các cách tiếp cận mới với mô hình ngôn ngữ lớn (LLM)'.