Bí mật sau thành công đầy ấn tượng của OpenAI: Phụ thuộc vào một 'kho dữ liệu số' do Google nắm giữ

'Không AI cướp việc': Nhiều người làm nội dung 'đảm đang' 2-3 công việc cùng lúc, mỗi tháng kiếm thêm hàng chục triệu nhờ sử dụng ChatGPT

Nếu bạn thuộc top những người giàu nhất thế giới như dưới đây, liệu ChatGPT còn cần thiết với bạn không?

Dùng chip 'tự sản xuất' ra mắt từ năm 2016, sức mạnh của siêu máy tính Google vượt qua hệ thống của NVIDIA dù đối thủ đang dẫn đầu thị trường chip AIMặc dù không chiếm thị phần như NVIDIA trong lĩnh vực chip xử lý AI, Google thực tế đã sở hữu từ lâu dòng chip xử lý AI riêng với hiệu năng vượt trội so với hệ thống của đối thủ.

Google mới đây đã công bố thông tin chi tiết về một trong những siêu máy tính dành cho phát triển AI của họ. Điểm đáng chú ý nhất là Google khẳng định máy tính này có hiệu suất xử lý nhanh hơn và hiệu quả hơn so với các hệ thống tương tự của NVIDIA.

Google đã tự phát triển chip xử lý AI Tensor Processing Units (TPUs) từ năm 2016, vượt qua NVIDIA với hiệu năng cao và chi phí thấp.

Mặc dù trước đây ít chú ý hơn đối thủ NVIDIA, nhưng Google thực ra đã sử dụng chip TPU riêng có hiệu năng vượt trội.

Google bắt đầu tăng cường sản phẩm AI của mình để chứng tỏ họ vẫn dẫn đầu trong lĩnh vực này, đặc biệt sau khi các sản phẩm như ChatGPT của OpenAI trở nên phổ biến.

Google xây dựng siêu máy tính với hàng ngàn chip TPU thế hệ thứ 4, cùng với linh kiện phần cứng tùy chỉnh, giúp huấn luyện mô hình AI.

Siêu máy tính TPU v4 của Google nhanh hơn và tiết kiệm năng lượng hơn so với NVIDIA A100.

Siêu máy tính TPU v4 của Google được coi là chủ lực cho các mô hình ngôn ngữ lớn với hiệu suất và tính khả dụng cao.

Mặc dù TPU v4 của Google vượt trội so với chip A100 của NVIDIA, nhưng có thể không duy trì được sức mạnh trước H100 mới nhất của NVIDIA.

Kết quả từ MLperf mới công bố cho thấy H100 của NVIDIA nhanh hơn đáng kể so với các phiên bản trước đó.

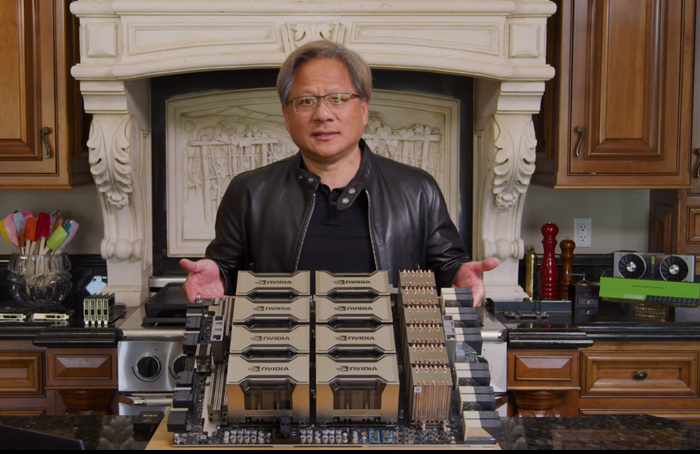

'MLPerf 3.0 đã chứng minh sức mạnh của H100, với hiệu suất gấp 4 lần A100,' CEO NVIDIA nói.

'Tầm quan trọng của AI sáng tạo đòi hỏi hạ tầng AI mới để đào tạo các mô hình ngôn ngữ lớn một cách hiệu quả về năng lượng,' CEO NVIDIA nêu rõ.

Các mô hình AI như Bard của Google và ChatGPT của OpenAI yêu cầu nhiều tài nguyên tính toán và hàng trăm hoặc hàng nghìn chip hoạt động cùng nhau để đào tạo.

Các con chip AI cần đủ mạnh để xử lý hàng terabyte dữ liệu nhanh chóng và thực hiện các nhiệm vụ như nhận dạng mẫu và suy luận.

Các siêu máy tính AI tiêu thụ lượng điện lớn, thúc đẩy sự phát triển của các con chip mới để tiết kiệm năng lượng.

Nhu cầu về năng lượng của AI tạo cơ hội kinh doanh cho các dịch vụ điện toán đám mây như Google, Microsoft và Amazon.

Các công ty này có thể cho thuê xử lý máy tính theo giờ hoặc cung cấp tín dụng tính toán cho các công ty khởi nghiệp.

Thông tin từ CNBC.